ERP、SFAツール、顧客管理システム、POSシステム・・・

現在では、様々なシステムを活用してビジネスを展開することが当たり前となりました。

それぞれのシステムを必要に応じて連携し利用することによって、組織全体としてシステムやデータをより有効に活用できます。

本コラムでは、システム連携の代表的な手法や課題などを解説します。

▲ 欲しい製品・ソリューションが見つけやすくなりました! |

| 目次 |

|---|

システム連携とは?

かつて、システムは一部の大企業だけのものであり、大型メインフレームの導入が主流でした。

しかし、1990年代以降にダウンサイジングの波が押し寄せ、現在は大企業だけではなく幅広い規模・業種の企業が業務別・目的別に最適化された多種多様なシステムを導入しています。

こうした中で、すでに多くの企業が取り組み始めているのがシステム連携です。システム連携とは、異なるシステム間でデータを相互に共有・処理できるようにすることです。

システム間で分断されていたデータの活用によって、より深い洞察を得たり、オペレーションエラーを減らしたりといった効果を得られます。

例えば、SFA(Sales Force Automation/営業支援)ツールと MA(Marketing Automation)ツールを連携することで、営業担当者やマーケティング担当者は、見込み客の獲得から最終的な受注に至るプロセスを俯瞰的に把握できるようになります。

その結果、マーケティング担当者はウェブサイトの流入数や見込み客の獲得数だけではなく、アポイントメント獲得数や最終的な受注数といった営業側の指標も見ながら、マーケティング施策の検証や効果改善に向けて精度の高い施策検討を行なえます。

また、勤怠管理システムと給与計算システムを連携すれば、勤務時間に応じた毎月の給与計算を自動化できます。

Excel などの表計算アプリでの集計など、人による作業工数の削減に繋がり、勤務時間管理や給与計算でありがちな計算ミスや誤入力といったオペレーションミスの防止に役立ちます。

次項でシステム連携を実現するための具体的な方法を解説します。

システム連携の代表的な方法

現在よく使われている代表的なシステム連携の方法は、以下の3つです。

- ファイル転送

- メッセージキュー

- API

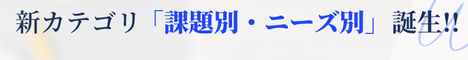

1.ファイル転送

ファイル転送はファイル単位で1対1でのシステム連携を実現する方法です。

長年にわたってシステム連携の代表的な手段として利用されてきました。

ファイル転送は FTP(File Transfer Protocol)、SMB(Server Message Block)、CIFS(Common Internet File System)といったプロトコルを用いて実現します。

FTP はファイル転送で利用される代表的なプロトコルの1つです。後述する方法に比べ、FTPの利点は大容量データを高速でやり取りすることです。

データ連携は通信プロトコルである FTP を通じて行うので、連携するシステムそのもののプログラムに手を加える必要がありません。

そのため、一方のシステムで障害が起きてももう一方のシステムへの影響範囲を限定できます。

一方、ファイル転送でシステム連携を実現する際にはファイルの静止点(※1)が必要です。

ファイル転送はデータを一括して転送するバッチ処理によって行われるので、全データの処理が完了しなければ結果がわからず、途中経過を把握できません。

そのため、リアルタイム処理のようにすぐ結果を知りたい場合は、1回のデータ量を減らして転送時間を短くするなどの工夫が必要です。

※1:ファイル内のデータが更新されていない状態のこと

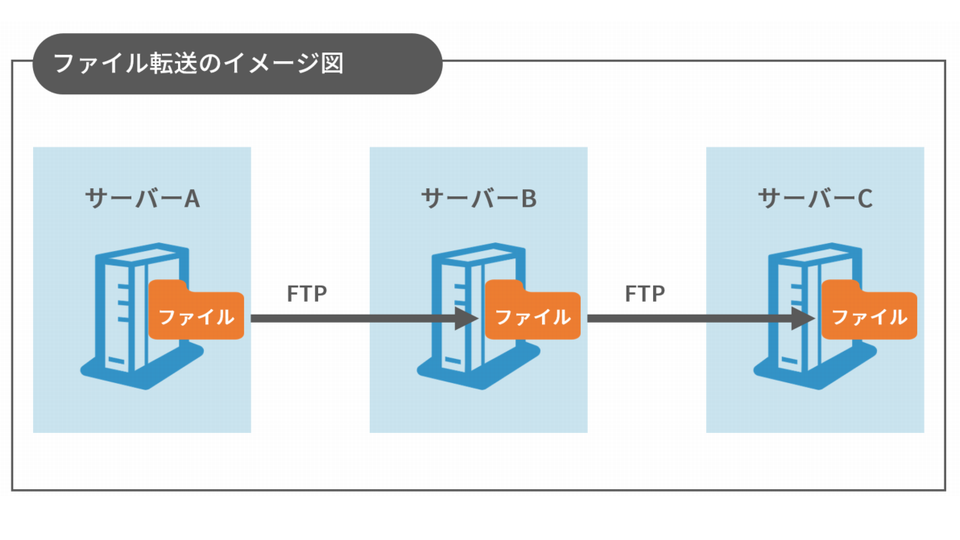

2.メッセージキュー

メッセージキュー(Message Queue)はメッセージ単位で N対1、または N対N でのシステム連携を実現する方法です。

送信側が送信したメッセージは受信側が取り出すまでデータ領域(キュー)に保管されます。

キューはメッセージ指向ミドルウェア(MOM:Message Oriented Middleware)やメッセージブローカー(Message Broker)で管理するのが一般的です。

送信側の処理はキューにメッセージを送信することで完了します。

直接受信側にデータが送信されるわけではないので、受信側のシステムの負荷やリソースなどを意識する必要はありません。

受信側でシステムダウンやリソースの逼迫があったとしても、送信側は処理の完了を待つ必要がないのです。

メッセージキューにおける送信側のメリットは「送信側が意図したメッセージの順序を維持することができる」ことです。

このような特性から、メッセージキューは非同期処理が必要なシステム連携に向いています。

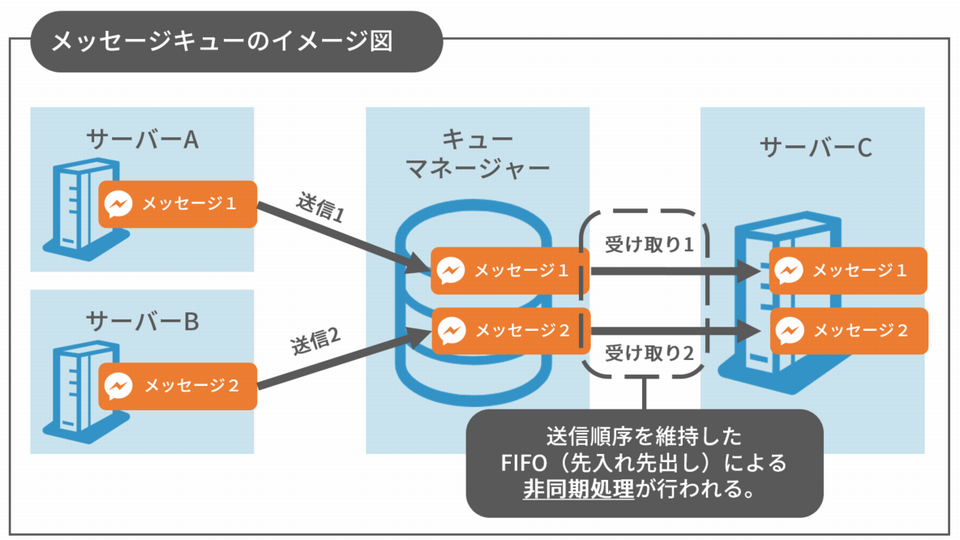

3.API

API(Application Programming Interface)は、HTTP や HTTPS形式で実装されることが多い、N対1 でのシステム連携を実現する方法です。

API はシステムの外部仕様を定義して各機能を利用するためのインターフェースを提供します。

そのため、多くの場合 API はシステムを構築する言語と同じ言語のライブラリと通信プロトコルで提供されます。

API を使用すると、そのシステムの実装方法を知らなくても他のシステムと連携可能です。

Webアプリケーションの特定の機能のみ API として実装して公開することで「社外の一般ユーザーが利用できるようにする」といったことができます。

例えば、下図のように社外の一般ユーザー向けに自社の Webサーバー上にある Webアプリケーションを提供した上で、ゲートウェイ上でアクセス制御を行うことで、セキュリティを担保できます。

幅広いシステム連携方法に対応するのはコストがかさみ、手間も増える・・・

前項で紹介したように、システム連携といっても様々な方法があります。

採用するべきシステム連携の方法は連携するシステムの仕様、やり取りするデータ量、データ形式などによって異なります。

例えば、CADデータをやり取りするといったようにシステム間で大容量データを送受信する場合には、FTP によるファイル転送が適しています。

一方、SaaS型ソリューションの多くが API を公開しているように、「顧客や取引先といった外部のユーザーが任意に特定のシステムと連携するための方法を提供したい」という場合には API が適しています。従来のように個別にシステム連携のプログラムを開発することなく、ユーザー側で連携作業を完了できるからです。

しかし、用途に合わせて複数のシステム連携の方法に対応するとなると複数のソリューションを導入しなければならず、製品ごとのライセンス・導入コストがかさんでしまいます。

また、利用するソリューションが多くなると運用管理の手間も煩雑化してしまいがちです。実情として、用途に応じてシステム連携の方法を使い分けるのはハードルが高いといえます。

一方、最近では様々なシステム連携の方法を統合的に運用管理できるプラットフォームが登場しています。

用途・目的に合ったシステム連携の方法を選べる統合プラットフォーム「IBM Cloud Pak for Integration」

IBM Cloud Pak for Integration は、IBM が提供している MQ(メッセージキュー)、App Connect(アプリケーション連携)、API Connect/DataPower(API連携)、Aspera(ファイル転送)といったシステム連携を実現する様々なソリューションを統合したプラットフォームで、システム連携をワンストップで実現できます。

また、IBM Cloud Pak for Integration は実績のある Red Hat OpenShift Container Platform で稼働し、コンテナ技術に最適化しているので、オンプレ、IBM Cloud、他社クラウドなど様々な環境にデプロイできます。

システム連携に課題を感じている方は、ぜひ、IBM Cloud Pak for Integration の検討をおすすめします。

詳細は[IBM Cloud Pak for Integration]でも紹介しています。

お問い合わせ

この記事に関するお問い合せは以下のボタンよりお願いします。

関連情報

- IBM Cloud Pak for Integration(製品情報)

– アプリケーション、データ、クラウド・サービス、APIの統合を支援するハイブリッド統合プラットフォームです。 - 今、デジタルサービスに求められる必須要件とは!?アプリケーションのコンテナ化で得られる5つのメリット(コラム)

– 今注目されている「コンテナ化」。コンテナ化とは?そのメリットとは? - 【やってみた】IBM Cloud Pak for Applications導入してみた:概要編(ブログ)

– シリーズ第1回目の本記事では、概要編として検証の目的・背景や環境周りを紹介します。 - 全ての企業が AI カンパニーになる!「IBM THINK Digital 2020」に参加した(ブログ)

– 全世界から9万人以上の参加者が!